量化起家,万卡在手,降价狂魔,Deepseek可能就是中国大模型混战的终结者

最近一段时间中国大模型领域变得异常热闹,最重要的话题就是各大模型公司的 " 价格战 "。

而事实上,这场让字节、阿里、百度、智谱等纷纷卷入的大混战,最初却是一个 " 神秘 " 的 " 金融公司 " 所掀起的。

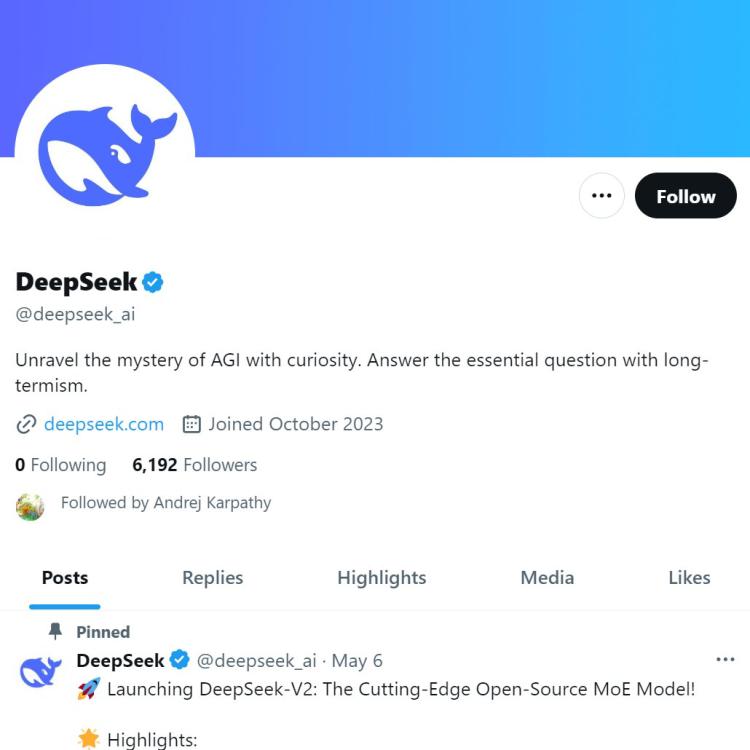

5 月 6 日,量化对冲基金幻方旗下的 AI 团队深度求索,发布了最新的模型,同时,宣布把 API 价格下调,降价幅度之大,使得它的价格只是 GPT-4 Turbo 的百分之一水平。很快,它引发了连锁反应。之后字节和阿里的陆续跟进,使得价格战正式铺开。

深度求索,和它模型的名字 "Deepseek" 似乎对大多数人来说都显得有些陌生,但在模型研究者和开源圈子里,它一度是被提及最多的模型和开发厂商之一,甚至在 Mistral 和 Llama 占据统治地位时,Deepseek 也有一批忠实拥趸。许多开发者尤其认为它的数学和推理能力极强,与那些追求玩弄吟诗作赋的模型差别明显。

最新的一个动作是,离开 OpenAI 的大神 Andrej Karpathy 也开始关注 Deepseek 的账号。

主业二级市场交易,却做起了 AGI;低调异常,却决定着整个行业走向;不怎么宣传,却受到社区自来水一片好评 ...... 这一系列的反差让这家公司更显神秘。

不过这种 " 神秘 " 可能并不会持续很久了。多位接近幻方的人士透露,幻方对深度求索接下来的计划是,让它独立面对市场。它将有可能成为看起来格局已定的中国大模型江湖里,最后一个玩家,也注定会是一个很能搅局的玩家。

被低估的 Deepseek

就像深度求索是价格战的 " 发起者 " 这件事被很多人忽视一样,Deepseek 这次的技术创新同样缺少讨论。在讲述深度求索这家公司之前,我们可以先看看此次发布的新模型上,Deepseek 的技术创新。

此次 Deepseek-V2 对架构层面做了创新,这是很多国产甚至全球范围的开源基座模型少有的尝试。

在架构方面,DeepSeek-V2 采用了 Transformer 架构,其中每个 Transformer 块由一个注意力模块和一个前馈网络(FFN)组成。然而,对于注意力模块和 FFN,研究团队设计并采用了创新的架构。

一方面,该研究设计了 MLA(Multi-head Latent Attention): 一种更好、更快的注意力,可通过减少 KV 缓存确保高效推理。

另一方面,对于 FFN 采用了高性能 MoE 架构 DeepSeekMoE,以经济的成本训练强大的模型。

DeepSeek 独创的 Sparse 结构 DeepSeekMoE 与 MLA 架构的结合,推动了 DeepSeek-V2 提升效率和性能。此模型仅需极小的内存用量(相当于对应密集型 ( Dense ) 模型的 1/5~1/100),就可发挥出相似于 70B~110B 密集型 ( Dense ) 模型的计算能力。

模型的高效率直接转换为显著的成本节约——在 8 卡 H800 机器上,DeepSeek-V2 的输入吞吐量可达每秒超过 10 万 tokens,输出超过每秒 5 万 tokens。

DeepSeek-V2 模型和论文完全开源,可免费用于商业用途。

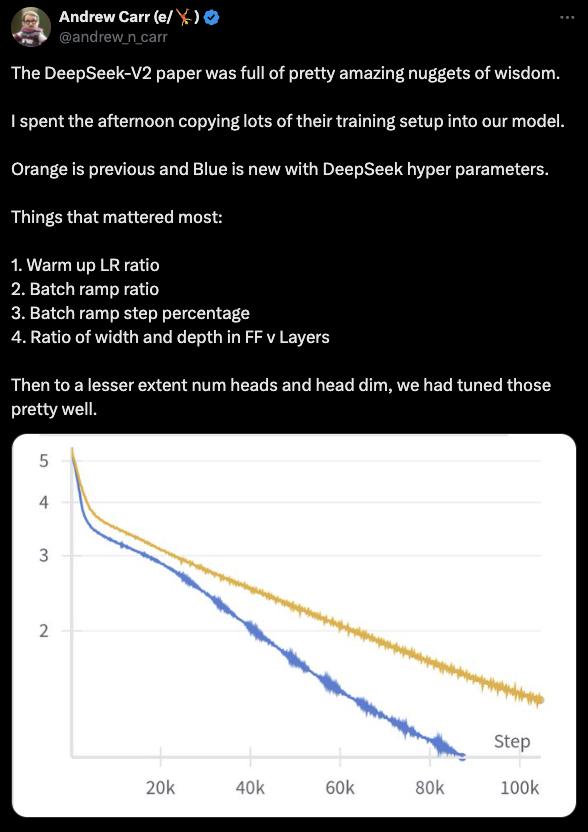

OpenAI 前员工 Andrew Carr 从 DeepSeek-V2 论文中获取灵感,将其训练设置应用于自己模型

DeepSeek-V2 每百万 tokens 输入 / 输出价格远低于行业平均水平,推理的成本的大幅降低,进一步降低了使用大型语言模型的门槛,例如在 AI 智能体等场景,需要频繁对话调用,需要大量 token 数量。价格的降低,有望带来更快的商业化落地,且可能提升用户体验。

一位 AI 开发者在 DeepSeek-V2 发布后表示,在他开发的 AI 游戏中,原本由大模型扮演的主持人是不会考虑历史消息。这就导致大模型的回答并不考虑用户已经掌握的信息,难以给出真正有启发性的、多样性的回答。而现在 DeepSeek API 的价格不到市面上同档次大模型的十分之一,他也可以尝试考虑加入历史消息了。

挑起价格战后,需要更多弹药了

DeepSeek-V2 是深度求索持续的模型更新的最新进展,它的能力提升明显,让开发者们记住了 DeepSeek 这个模型系列,而更重要的,是 DeepSeek 的站稳脚跟,让深度求索可以被按照一家模型层的公司来估值。

据知情人士对硅星人称,幻方对深度求索有独立拆分上市的计划。而此次 " 价格战 " 的进展,正在让这个计划的进程加快。

深度求索挑起的 " 价格战 ",最初对它来说是个 " 自然而然的事情 "。

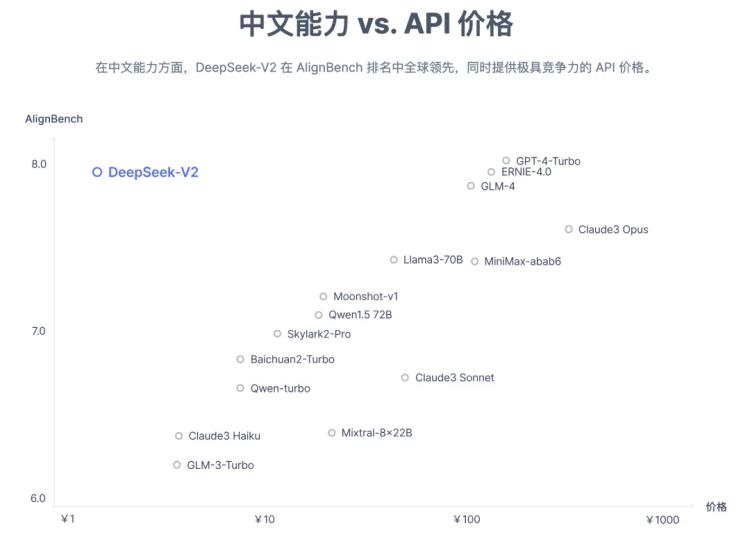

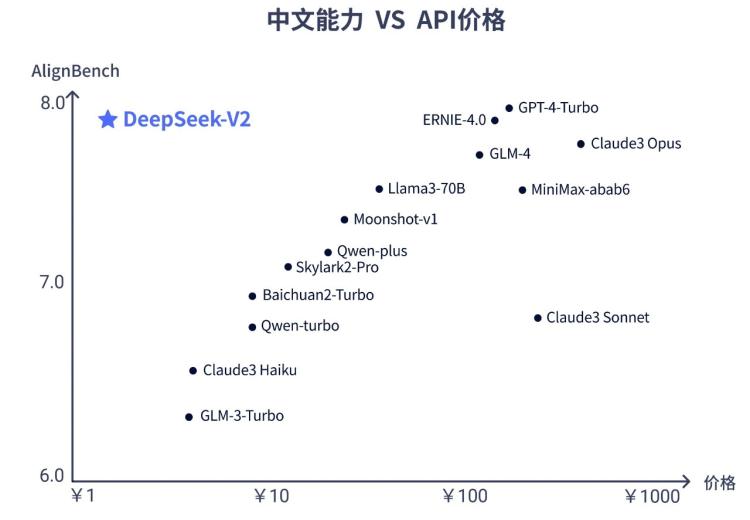

5 月 6 日深度求索(DeepSeek)发布 DeepSeek-V2 时表示,DeepSeek-V2 中文综合能力(AlignBench)开源模型中最强,与 GPT-4-Turbo,文心 4.0 等闭源模型在评测中处于同一梯队。英文综合能力(MT-Bench)与最强的开源模型 LLaMA3-70B 同处第一梯队,超过最强 MoE 开源模型 Mixtral 8x22B。知识、数学、推理、编程等榜单结果也位居前列。同时支持 128K 上下文窗口。

DeepSeek-V2 拥有 2360 亿参数,其中 210 亿个活跃参数。160 位专家,其中有 6 位在生成中活跃。DeepSeek-V2 在包含 8.1 万亿 token 的语料库上进行预训练,并通过监督微调 ( SFT ) 和强化学习 ( RL ) 来进一步提升模型能力。

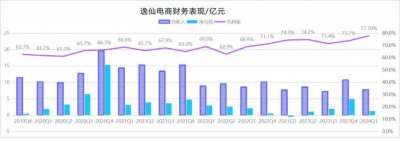

价格战是这些模型能力的 " 附加物 " ——在能力接近第一梯队闭源模型的前提下,DeepSeek-V2 API 的定价为每百万 tokens 输入 1 元、输出 2 元(32K 上下文),价格仅为 GPT-4-Turbo 的近百分之一。深度求索对这个价格的解释是,它并不是补贴,而是,这 " 目前就是大规模服务的价格,不亏本,利润率超 50%"

一方面技术过硬直接把价格打下来,另一方面,这些训练部分的资金,并不像后来跟进价格战的一批创业公司那样来自 VC 们的融资——深度求索目前的弹药是幻方自己的。

而价格战正式打响后,事情开始起变化。

随着诸多资金更加雄厚的大厂的跟进,这场 " 价格战 " 为代表的模型市场的激烈竞争开始显得更焦灼。

幻方核心业务所处的量化基金领域也在经历调整,此前的烧自己的钱,让研究团队可以自由而心无旁骛的研究的方式,在面对更加激烈的外部竞争压力下,也在发生变化。不烧 VC 的钱的状况可能改变。

最后的玩家登场

这意味着深度求索可能成为中国大模型江湖里最后一个重要玩家。

由于不在大模型的 " 圈子 " 里,深度求索的发展历程鲜少被提及。但它其实并非一个 " 不务正业 " 的临时组织。

提到深度求索,绕不开的就是其背后的量化投资公司幻方量化,幻方量化是一家依靠数学与计算机科学进行量化投资的对冲基金公司。

幻方创始团队自 2008 年起探索自动化交易。2015 年幻方量化创立,依靠数学与人工智能进行量化投资,并在 2016 年首次将深度学习模型应用于实盘交易,使用 GPU 进行计算,并持续投入 AI 算法研究。

此后,幻方不断壮大 AI 团队,转向 AI 驱动的量化策略,并面临算力挑战。2019 年至 2021 年间,幻方相继自主研发了 " 萤火一号 " 与 " 萤火二号 "AI 集群,其中 " 萤火二号 " 投资达到 10 亿元,极大提升算力支持。

而建设萤火集群的过程中,深度求索的前身出现。

在 ChatGPT 横空出世时,人们发现在中国拥有高性能 GPU 芯片最多的不是人工智能公司,而是幻方。据国盛证券研报,在云算力端,当时除了几家互联网公司,就只有幻方有超过 1 万张 A100 芯片储备。

作为一个需要 GPU 做量化的金融机构,囤积一些显卡很正常。但买了 1 万张并且自己建起集群,就 " 不正常 " 了。

事实上,幻方的集群最初就是在做金融之外的事情。

据一名很早接触过幻方的算法科学家称," 幻方当时的确有大量的卡,而早期他们买这些卡是在做‘慈善’——他们当时其实没有全部给自己用,而是用了很低的价格提供给各种需要更多的卡做算法研究的机构来使用。" 公开资料可以查询到,在萤火建成后的几年,有多篇登上 nature 等顶级期刊的论文,背后算力是由幻方支持。

这个决定自然很大程度来自创始人。

公开资料里,关于幻方创始人梁文锋的信息不多。一名很早接触过幻方创始人梁文锋的大模型创业者称,梁文锋对生成式 AI 技术是有自己的很深的研究和跟踪的。他们第一次见面时,这位掌管着千亿资金的 " 金融家 " 一上来就拿这位明星创业者早期发过的一篇论文中的一个公式,向后者请教,并提出了自己的想法。这让他印象深刻。

而幻方在搭建 " 萤火 " 集群中心团队的同时,也积极招募了一批算法科学家。多个业内 AI 研究人士称,幻方在这些年聚集了一大批能力很强的华人 AI 从业者。一名从 Google 总部回国加入幻方的员工就曾形容幻方内部文化很像 Google 美国。" 老板本人每天都在写代码、跑代码。"

幻方当时布置这些科学家做 AI 基础设施层产品,以及一些包括 AI for Science 的纯研究的工作。

这些多少都让人想到 OpenAI 的文化和氛围。

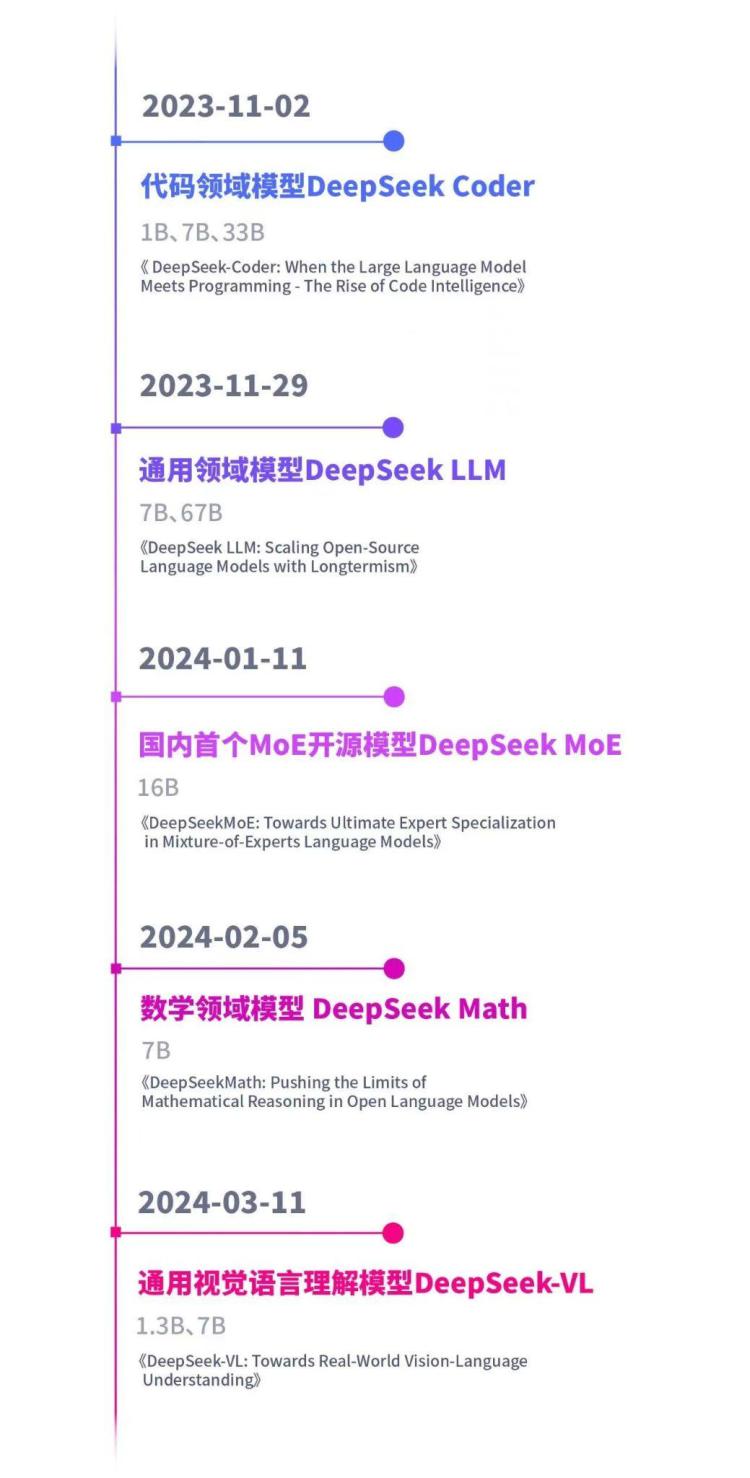

2023 年 5 月,幻方正式把萤火团队的定位集中在做大模型,成立独立新组织,命名为 " 深度求索 ",并强调将专注于做真正人类级别的人工智能。其目标不只是复刻 ChatGPT,还要去研究和揭秘通用人工智能,尝试拓宽人类对人工智能的认识和理解,此前已发布包括混合专家语言大模型、代码大模型、视觉语言模型在内的多个模型:

大模型行业的产品负责人 orange.ai 向硅星人表示,深度求索的显卡依托幻方的积累,在国内大模型创业公司里的显卡数量应该是前三的。这个团队对技术追求比较高,技术实力是非常强的。他们在国内最早发布了 MoE 模型,还直接开源。最近发布的 V2 模型则在 MoE 架构上进行了巨大的优化,让推理成本下降了至少一个数量级。还有一些视觉相关的模型业界口碑也很好。

" 只是他们很少宣传,一般用户都不知道。而且之前没有投入做 C 端产品,这样可能会产生一种模型指标很好,但是端到端体验不够好的问题,比如一些特定任务的指令遵循方面还是有进步空间的。"

显然,这些挑战,如果以一个更加独立的 " 大模型公司 " 的身份来权衡和解决,就更加容易了。

而就在 5 月 15 日,深度求索宣布 DeepSeek Chat 已正是通过国家备案,告别内测,正式向公众开放服务。

今年是幻方成立的第九年,在 " 舶来品 " 量化基金领域它是一个全华班的本土化特例,用一套接地气又思路新奇的打法改变已有格局取得了成功。

今天它正在让这个故事在大模型领域重演。深度求索也在成为看似格局已定的中国大模型行业里的最独特的搅局者。