傅盛周鸿祎同台泯恩仇,发布单卡可部署的百亿模型

" 下面一起聊碰到 AI 的东西,放心,我来跟他是放心碰撞的,不是怼。"

2024 年 1 月 21 日,360 创始人周鸿祎罕见现身猎户星空的大模型发布会,与猎户星空董事长傅盛,进行了一场隔了 16 年的同台对谈。

周鸿祎与傅盛同台对谈。图源:直播截图

早年间,傅盛曾是周鸿祎在 360 的得力干将,其带领团队探索的业务 360 安全卫士,在 2006 年的日均安装量已经达到 20 万。但由于发展理念不合,2008 年 10 月,傅盛辞职离开 360,并与雷军合作创办竞品公司金山网络。2011 年,360 以窃取机密资料为由,与傅盛对簿公堂。

而让双方在公开场合一笑泯恩仇的,则是被周鸿祎视为 " 这辈子经历 PC、互联网、移动互联网之后第四次巨大的机会 " 的AI 大模型。

在圆桌对谈中,傅盛和周鸿祎两人对 AI 模型层和应用层的创业,有以下观点:

AI 不是操作系统,而是更像当年人人配备的 PC,难以被两三家企业垄断;

大模型一定会两级分化:一条路是在云端越做越大,另一条路是把大模型做小;

训千亿大模型是大公司的活,资金资本消耗太大,但从应用出发去找好的场景把 AI 技术用好,是很好的机会;

ToC 产品无法用定制去解决,核心在于让每个人感受到独特的价值。今天的大模型做 ToC,除了套皮之外想做深不容易;

AI 对原有业务的改进更适合有一定规模的公司,AI 原生业务更适合早期的公司;公司要重视组合式的创新,把非 AI 的部分做到能让 AI 做起来;

因为行业套件还不成熟,真正 ToC 的 AI 原生应用还需要一两年。

傅盛提到,未来千亿参数规模的模型将半凋零,百亿规模的模型必将绽放。而猎户星空在模型的布局上,走的也是 " 把大模型做小 " 的路子。

此次猎户星空发布的是一款 140 亿参数的中型规模的大模型 Orion-14B,在一张消费级的千元显卡上就能部署,针对的是企业的专业场景。

Orion-14B 在 NVIDIA RTX 3060 显卡上推理速度可达 31 Token/s ( 约每秒 50 汉字 ) 。图源:猎户星空

与众多国内外 200 亿参数规模的模型相比,Orion-14B 在 MMLU、C-Eval、BBH 等中英主流测试集上拿下 SOTA(最佳模型),并且在 700 亿参数以下基座模型中,在中文数据集的表现上总分位列榜首。

基于第三方机构 OpenCompass 独立评测结果。图源:猎户星空

对于榜单上的好成绩,猎户星空也表示,Orion-14B 没有提前刷基准测试里面的真题,成绩绝对真实。

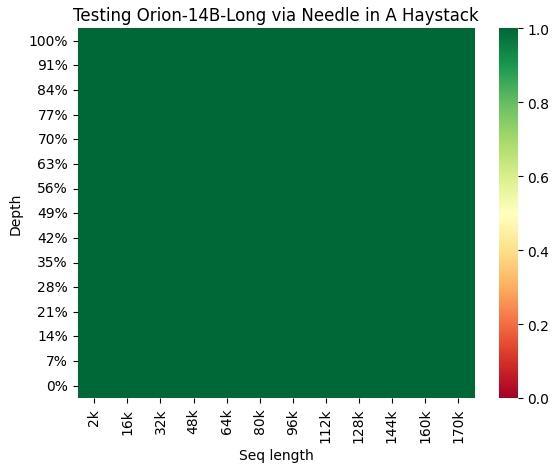

此外,Orion-14B 单次可推理 320K 的上下文,相当于一次性看完约 50 页的小说(45 万字)。而在针对大模型 " 记忆力 " 的权威测试 " 大海捞针(Needle in A Haystack)" 中,Orion-14B 对 200k Token 的召回率是 100%。

图源:猎户星空

傅盛并不避讳承认 Orion-14B 的训练,基于的是 8 个开源的 MoE(专家混合模型)。目前,Orion-14B 也已经在 GitHub、Hugging Face、ModelScope 等平台开源。

同时,傅盛指出,ChatGPT 只从公开出版物上获取数据,后果是无法深入解决企业问题。

落地到具体的企业应用场景,模型要解决的问题,一是幻觉和错误,二是缺乏自主性。

针对幻觉和错误问题,猎户星空推出了 RAG 能力微调模型 Orion-14B-RAG。所谓的 RAG(检索增强生成),能够从数据源中检索信息来复制大模型生成答案。Orion-14B-RAG 对知识边界控制、问答对生成、幻觉控制、结构化数据提取等能力,进行了专项微调,让其能更好配合企业整合自身知识库,构建定制化的应用。

针对构建自主性,猎户星空推出了辅助企业构建 AI Agent 的插件能力微调模型 Orion-14B-Plugin。该插件能够通过 Orion-14B-RAG 更好理解用户需求,并调用相关的工具解决问题。

附:

Orion-14B 技术报告 https://github.com/OrionStarAI/Orion/blob/master/doc/Orion14B_v3.pdf

欢迎交流