估值飙升,Mistral AI成微软第二条“大腿”

出品 | 虎嗅科技组

作者 | 杜钰君

编辑 | 王一鹏

头图 | 视觉中国

是 GPT-4 的劲敌兼平替,也是微软部署的又一利器。这家人工智能初创公司用实力让众人惊呼 " 微软赢麻了 "。

2 月 26 日,总部位于巴黎的人工智能公司 Mistral AI 发布尖端文本生成模型 Mistral Large。该模型达到了顶级的推理能力,可用于复杂的多语言推理任务,包括文本理解、转换和代码生成。

同日,微软宣布与 Mistral AI 建立多年合作伙伴关系,表示 "Mistral AI 是先锋,它是一位创新者和开拓者。他们对培育开源社区和实现卓越性能的承诺与 Microsoft 开发值得信赖、可扩展且负责任的 AI 解决方案的承诺和谐一致 "。

图 1:Microsoft 官网对双方合作的宣布

一、Mistral AI 的崛起之路

微软并不是第一家在 Mistral AI 身上押注的巨头。

Mistral AI 于 2023 年 5 月正式注册成立,创始人是谷歌 DeepMind 和 Meta 的校友。仅仅成立几周后,2023 年 6 月,Mistral AI 就获得了由 Lightspeed Venture Partners(光速创投)领投的 1.05 亿欧元(约合 1.13 亿美元)种子轮融资,使公司估值飙升至 2.4 亿欧元。仅半年后,Mistral AI 又获得了由 Andreessen Horowitz(a16z)领投的 3.85 亿欧元(约合 4.15 亿美元)融资,英伟达、Salesforce、法国巴黎银行等多家知名机构跟投。而到了 2024 年 2 月,微软更是直接入股 Mistral AI。

从初创到被巨头青睐,Mistral AI 只用了短短几个月。

资金加持下,这个仅 20 名左右员工的公司频频展示自己的硬实力。

9 月,Mistral 7B 发布,被称为当时 " 最强的 70 亿参数开源模型 "。

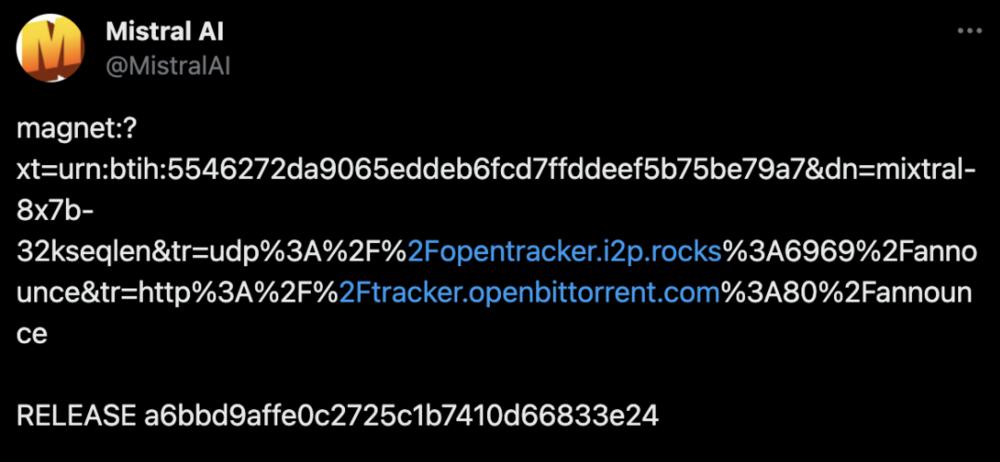

紧接着,12 月,Mistral AI 在无发布会、无宣传预热的情况下默默甩出一条磁力链接,发布了首个开源 MoE 大模型 Mistral 8x7B。87GB 的种子、8x7B 的 MoE 架构使得 Mistral AI 的身价一路飙升,几天后估值便高达 20 亿美元,与初创时间相比翻了 8 倍。

图 2 :Mistral AI 的开源 MoE 大模型 Mistral 8x7B 的磁力链接

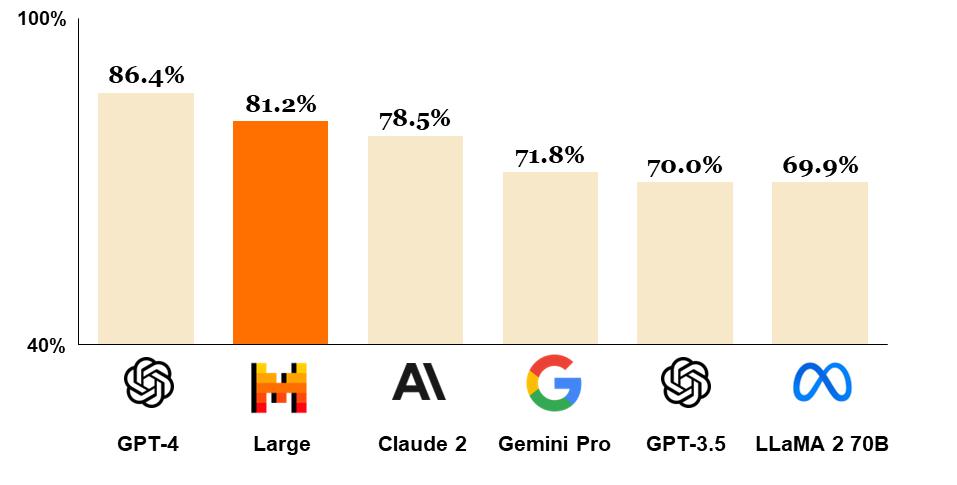

而 2 月 26 日发布的 Mistral Large,则直接叫板 GPT-4,在 MMLU (一个包含 57 个多选问答任务的英文评测数据集,是目前主流的 LLM 评测数据集)测试中的成绩仅次于 GPT-4 ,成为世界上排名第二的可通过 API 普遍使用的模型。

图 3:GPT-4、Mistral Large(预训练)、Claude 2、Gemini Pro 1.0、GPT 3.5 和 LLaMA 2 70B 在 MMLU 上的比较

Mistral Large 具有新的功能和优势:

它的母语是流利的英语、法语、西班牙语、德语和意大利语,对语法和文化背景有细致入微的理解。

其 32K 标记上下文窗口允许从大型文档中精确调用信息。

其精确的指令遵循使开发人员能够设计他们的审核策略——我们用它来设置 le Chat 的系统级审核。

它本身就能够进行函数调用。这与在 la Plateforme 上实施的受限输出模式一起,实现了大规模应用程序开发和技术堆栈现代化。

如今,Mistral AI 的估值已超过 20 亿欧元(约合 156.2 亿元人民币)。

二、GPT-4 的 " 劲敌 " 与 " 平替 "

根据 Mistral AI 官网介绍,Mistral Large 在知识推理、多语言能力、数学与编码等多方面的性能都直逼 GPT-4,成为了 GPT-4 不容小觑的劲敌。

(一)推理和知识

Mistral Large 展现出强大的推理能力。下图是 Mistral Large 预训练模型在标准基准上的性能。

图 4:市场上领先的 LLM 模型在广泛常识、推理和知识基准上的表现:MMLU(测量理解中的大规模多任务语言)、HellaSwag(10-shot)、Wino Grande(5-shot)、Arc Challenge(5 次)、Arc Challenge(25 次)、TriviaQA(5 次)和 TruthfulQA。

(二)多语言能力

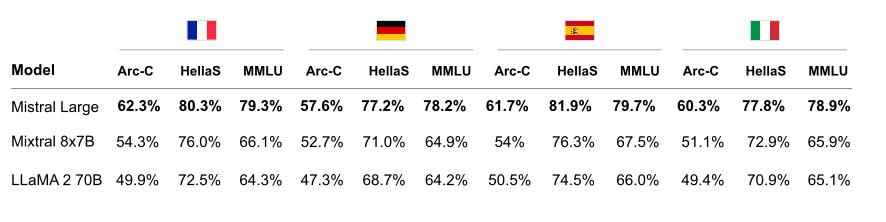

Mistral Large 具有本地多语言能力。它在法语、德语、西班牙语和意大利语的 HellaSwag、Arc Challenge 和 MMLU 基准测试中明显优于 LLaMA 2 70B。

图 5:Mistral Large、Mixtral 8x7B 和 LLaMA 2 70B 在 HellaSwag、Arc Challenge 和 MMLU 上法语、德语、西班牙语和意大利语的比较

(三)数学与编码

Mistral Large 在编码和数学任务中表现出顶尖的性能。在下表中,我们报告了一系列流行基准的性能,以评估一些顶级 LLM 模型的编码和数学性能。

图 6:市场上领先的 LLM 模型在流行编码和数学基准上的性能:HumanEval pass@1、MBPP pass@1、Math maj@4、GSM8K maj@8 和 GSM8K maj@1

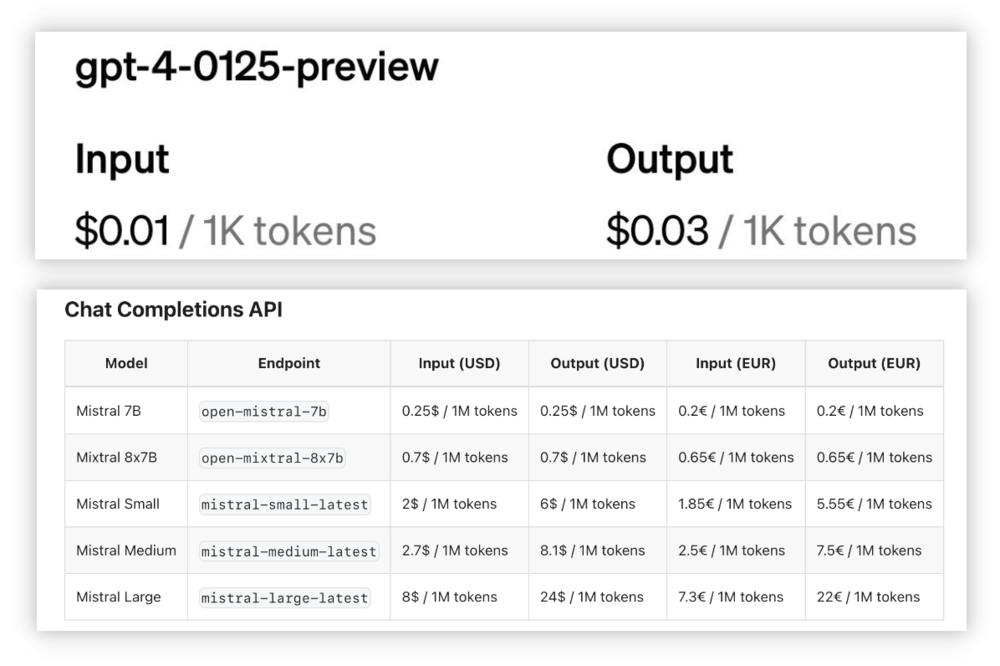

在性能上叫板 GPT-4 的同时,Mistral Large 的应用成本更为低廉。目前,查询 Mistral Large 的成本为每百万个输入代币 8 美元,每百万个输出代币 24 美元。在人工语言术语中,标记代表小块的单词——例如,当人工智能模型处理时,单词 "TechCrunch" 将被分成两个标记,"Tech" 和 "Crunch"。

默认情况下,Mistral AI 支持 32k 个标记的上下文窗口(通常超过 20,000 个英语单词)。作为比较,GPT-4 Turbo 具有 128k 代币上下文窗口,目前每百万个输入代币的成本为 10 美元,每百万个输出代币的成本为 30 美元。因此,Mistral Large 目前比 GPT-4 Turbo 便宜 1.25 倍,成为了 GPT-4 Turbo 的 " 平替 "。这对于使用量巨大的企业用户而言可以节省很大一笔开支。

图 7:Mistral Large 与 GPT-4 及其同源产品的成本比较

除了 Mistral Large 之外,这家初创公司还推出了自己的 ChatGPT 替代品,即 Le Chat 的新服务。该聊天助手目前处于测试阶段。该公司还计划为企业客户推出 Le Chat 的付费版本。除了集中计费之外,企业客户还能够定义审核机制。

不仅如此,Mistral AI 的商业模式看起来也越来越像 OpenAI 的商业模式。目前,该公司的模型不再像成立初时完全开源,而是通过付费 API 提供 Mistral Large,并根据使用情况进行定价。Mistral Large 可通过 la Platform 获取,也可以在 Azure AI 上使用。其中,La Plateforme 这一接入点安全托管在欧洲的 Mistral 基础设施上,使开发人员能够在模型范围内创建应用程序和服务;同时该模型也可通过 Azure AI Studio 和 Azure 机器学习使用。

三、与微软的双向赋能

Mistral 的先进模型资源将安放在微软云中,使其成为全球第二家在微软 Azure 上提供商业 AI 模型的公司。

Mistral AI 与微软的合作重点关注三个核心领域:

超级计算基础设施:微软将通过 Azure AI 超级计算基础设施来支持 Mistral AI,为 Mistral AI 旗舰模型的 AI 训练和推理工作负载提供一流的性能和规模。

扩展到市场:微软和 Mistral AI 将通过 Azure AI Studio 和 Azure 机器学习模型目录中的模型即服务 ( MaaS ) 向客户提供 Mistral AI 的高级模型。除了 OpenAI 模型之外,模型目录还提供开源和商业模型的多种选择。用户可以使用 Microsoft Azure 消费承诺 ( MACC ) 来购买 Mistral AI 的模型。Azure 的 AI 优化基础设施和企业级功能为 Mistral AI 提供了向全球 Microsoft 客户推广、销售和分发其模型的额外机会。

人工智能研究和开发:微软和 Mistral AI 将探索围绕为特定客户(包括欧洲公共部门工作负载)培训特定目的模型的合作。

对此,Mistral AI 首席执行官 Arthur Mensch 表示,与微软的合作使 Mistral AI 能够访问 Azure ,推动其创新研究和实际应用程序向世界各地的新客户发展,加速下一代大型语言模型 ( LLM ) 的开发和部署,为 Mistral AI 提供了释放新商业机会、扩展到全球市场的机会,并促进持续的研究合作。

这不仅是 Mistral AI 迈向商业化的重要一步,同时也是微软在 AI 领域深化布局的又一力证。对于微软而言,和 Mistral AI 的开放合作伙伴关系策略是让 Azure 客户留在其产品生态系统中的好方法。此外,微软与 OpenAI 多年的关系已经吸引了美国和欧洲反垄断监管机构的审查,与 Mistral AI 等大模型公司的合作无疑可以 " 分散火力 "。当前,微软正积极探索在其云计算平台上与其他人工智能模型点合作可能。例如,Microsoft 和 Meta 合作在 Azure 上提供 Llama 大型语言模型。

事实上,Mistral AI 的在研产品不止于 Mistral Large。

Mistral AI 的模型产品主要分为 Mistral Small、Mistral Large、Mistral Embed 三类。其中,Mistral Small 受益于与 Mistral Large 在 RAG 启用和函数调用方面相同的创新,主要提供针对低延迟工作负载的经济高效推理;Mistral Large 主要用于处理高复杂性任务的顶级推理;Mistral Embed 则主要用于提取文本摘录表中最先进的语义。